The Origins of Artificial Intelligence (AI) in Translation: Evolution, Technology, and Impact on the Language Industry

Authors: Krittiwat Nakwong, Wanitcha Sumanat

12 August 2025, Bangkok – Translation is a discipline that has accompanied humanity for a long time, serving as a bridge that connects cultures, languages, and knowledge. However, with the advent of the digital age, Machine Translation (MT) has become a significant turning point in this field. Especially since artificial intelligence (AI) began to play a serious role from the late 20th century onward, AI development has driven translation technology to evolve from traditional rule-based systems to Statistical Machine Translation (SMT), and subsequently to Neural Machine Translation (NMT) systems, which are capable of understanding context, meaning, and complex language patterns on a much deeper level.

Beyond increased accuracy and speed, AI has made translation more accessible across broad sectors such as business, education, and everyday life. Nonetheless, the growth of AI has also directly impacted the role of professional translators in terms of necessity, skills, and professional ethics. This article aims to study the development of AI in language translation from the past to the present, analyzing the technological dimensions, real-world industry applications, and the resulting implications for the future of the translation profession.

The Beginning of Machine Translation: The Georgetown–IBM Experiment

The history of Machine Translation can be traced back to a landmark computational linguistics experiment in 1954 known as the Georgetown–IBM experiment, which is considered the official starting point of Machine Translation (MT). The IBM 701, IBM’s first computer, was programmed to translate 60 Russian sentences into English under a system that relied entirely on hand-crafted grammar rules and dictionaries.

The Georgetown, IBM experiment, conducted on January 7, 1954, marked a significant milestone in the history of artificial intelligence (AI) and computational linguistics. It was the first public demonstration of language translation using a computer system (machine translation), held at IBM’s headquarters in New York City.

The collaboration between Georgetown University and IBM showcased the feasibility of using computers to process human language. Using the IBM 701—IBM’s first commercial digital computer, the system automatically translated over 60 Russian sentences into English. Although the system was very limited in scope, relying on only six grammar rules and a vocabulary of about 250 words (including roots and inflections) focused exclusively on organic chemistry, the demonstration carried immense symbolic and strategic significance. The sentences chosen were carefully selected to cover topics such as politics, law, mathematics, chemistry, metallurgy, communication, and the military. The data entry operators did not need to understand Russian; they could simply use the system to translate and print the English output automatically.

The main purpose of the experiment was to generate public and governmental interest and support to promote investment in language technology research. This goal was highly successful, as the media widely covered the event and portrayed a vision of a future in which machines could accurately understand and translate human languages. Although the translations produced were far from perfect and the system lacked true syntactic analysis, the experiment demonstrated that “computers can translate language”, the first time a computer was shown to do more than just number crunching. This breakthrough became a major impetus for further advanced research in artificial intelligence (AI), natural language processing, and future machine translation development.

Therefore, the Georgetown, IBM experiment was not only the beginning of AI but also the starting point for questioning the potential of machines to understand language and meaning, questions that remain central to AI development today.

Rule-Based Machine Translation (1950s–1980s): The Foundation of Language Engineering

The period from the 1950s to the 1980s was the era of Rule-based Machine Translation (RBMT), a system that relied on linguistic rules crafted by experts. These rules covered grammar structures, bilingual dictionaries, and transformation rules from one language to another. RBMT operated by analyzing sentences at the syntactic and morphological levels before translating them into the target language. There were two main approaches: the interlingual approach, which used a language-independent intermediate representation extracted from the source language and then converted into the target language, and the transfer-based approach, which translated the source language into language-pair-specific rules before producing the target language output. The latter approach was more popular due to the extreme difficulty of designing truly language-independent rules.

Historically, RBMT took shape after the Georgetown–IBM demonstration in 1954 and was heavily supported by Cold War-era funding, such as U.S. government projects for translating technical and military documents. This support led to flagship commercial systems like SYSTRAN, Logos, and Ariane-G5, as well as Japan’s investment in the Fifth Generation Computer Project.

However, the strengths of RBMT—such as transparency of rules and engineering control—became significant limitations when confronted with the complexity and ambiguity of natural language. Each language pair required an enormous number of rules and vocabulary entries, leading to high development and maintenance costs. It was difficult to scale to new subject areas or languages, and the output often sounded rigid and unnatural. By the 1980s, corpus-based approaches began to supplant RBMT as large bilingual corpora became available. Nevertheless, RBMT laid the groundwork for computer-assisted translation by proving that computers could process human language using systematic linguistic knowledge—a crucial first step toward future developments.

The Statistical Revolution (Statistical MT: 1990–2010)

With the rise of more powerful computers in the 1980s, researchers began developing Statistical Machine Translation (SMT), which relied on learning from parallel corpora—large datasets of aligned source and target texts. Unlike RBMT, SMT did not depend on hand-coded grammatical rules but used statistical probabilities to predict the most likely translations.

Statistical Machine Translation, which gained prominence from the 1990s through around 2010, marked a pivotal shift by expanding the scope and improving the quality of automated translation. SMT was fully data-driven, learning probabilistic models between phrases or word units in the source and target languages. It could calculate the likelihood of translated sentences without relying on human-crafted grammar rules. This line of research originated with the IBM Thomas J. Watson Research Center team, inspired by Claude Shannon’s information theory and Warren Weaver’s proposals on applying statistics to language decoding since 1949.

Advancements in the 1990s coincided with the emergence of high-performance computers and digital corpora, enabling national projects such as Germany’s Verbmobil and the U.S. DARPA programs to push SMT forward in both text and speech translation.

Commercially, SMT was widely adopted by major services such as Google Translate (2007–2016) and SYSTRAN’s offerings, expanding automated translation markets far beyond previous boundaries. Although SMT greatly extended coverage and drastically reduced system preparation time, it still faced challenges in producing natural language, handling long-distance syntactic dependencies, and requiring large, high-quality corpora. This led to the gradual replacement of SMT by Neural Machine Translation (NMT) systems from around 2010 onward, which used neural networks to process entire sentences.

Nevertheless, SMT proved the power of statistical approaches in enabling computers to learn aspects of language translation with limited human intervention and laid an undeniable foundation for the automatic translation systems we use today.

Neural Machine Translation (NMT): A Turning Point into the Modern Era

The mid-2010s marked the era of Neural Machine Translation (NMT), which uses neural networks—especially Recurrent Neural Networks (RNNs) at first, and later the Transformer architecture, pioneered by Google. This was a major leap forward in computer-based translation, as the neural networks could learn contextual relationships across entire sentences rather than processing individual words or phrases in isolation, as previous methods did.

Although early exploration of neural network-based machine translation occurred in the 1980s and 1990s—such as Robert B. Allen’s 1987 Feed-Forward model and Recursive Auto-associative Memory Networks—limited computing power and data kept Statistical Machine Translation (SMT) dominant for a long time.

In 2014, Google introduced the sequence-to-sequence (seq2seq) model using RNNs, which encoded entire sentences into numerical vectors before decoding them into the target language. The introduction of the attention mechanism allowed the decoder to refer back to important words in the source sentence during translation, resulting in smoother and more fluent output.

The arrival of the transformer architecture in 2017 significantly improved both accuracy and speed, enabling NMT to handle multiple languages with lower memory requirements than statistical methods. It also managed long-distance dependencies in sentences much better. Moreover, the end-to-end training approach, which processes everything in a single step without manual feature engineering, reduced the need for linguistic expertise from humans. This opened doors for applications beyond text translation, such as speech translation, summarization, and intelligent chatbots.

Industry adoption quickly followed. Google Translate switched from SMT to NMT in 2016, soon followed by Microsoft Translator, DeepL, and Baidu, establishing NMT as the standard for modern translation. Thanks to its near-human quality output and ability to adapt to unseen contexts, NMT is more than just a “method”—it is a pillar of natural language processing in the AI era and continues to evolve relentlessly.

New AI Era: Real-Time and Adaptive Translation Systems

Since 2020, we have entered an era of Adaptive Machine Translation (AMT) and Real-time AI Translation Systems, which learn from user feedback and adjust translations dynamically to suit specific contexts—such as tone, domain-specific terminology, or even speaker accent.

Adaptive Machine Translation (AMT) is the latest advancement that combines Neural Machine Translation with real-time learning processes. Starting from a base model trained on parallel corpora, the system continuously learns from human post-editing corrections. This allows the model to immediately update its translation behavior whenever users confirm or correct translated sentences, improving quality continuously without waiting for periodic retraining, unlike traditional batch models.

Key advantages of AMT include:

- Real-Time Learning: Every user correction instantly influences the next output, reducing repetitive errors.

- Human-in-the-Loop: Maintains the role of professional translators while boosting productivity by 30% to 60%.

- Customization: Adapts to individual user’s tone, technical vocabulary, and style.

- Cost Efficiency: Reduces post-editing workload and cuts costs compared to batch retraining on large datasets.

Commercial implementations such as ModernMT, Lilt, Amazon Translate Adaptive, SYSTRAN Pure Neural Server, and Language Weaver demonstrate that AMT can flexibly integrate with Translation Memories (TM) and terminology databases to enhance localization effectiveness.

This instant feedback processing capability makes AMT especially suitable for high-stakes documents—like legal, medical, and engineering texts—as well as fast-paced translation needs such as live chat or daily product manual updates. Hence, AMT represents not only quantitative improvements in translation quality but also a paradigm shift from “translation assistance tools” to “AI-powered translation systems” that learn from humans and evolve alongside global language demands.

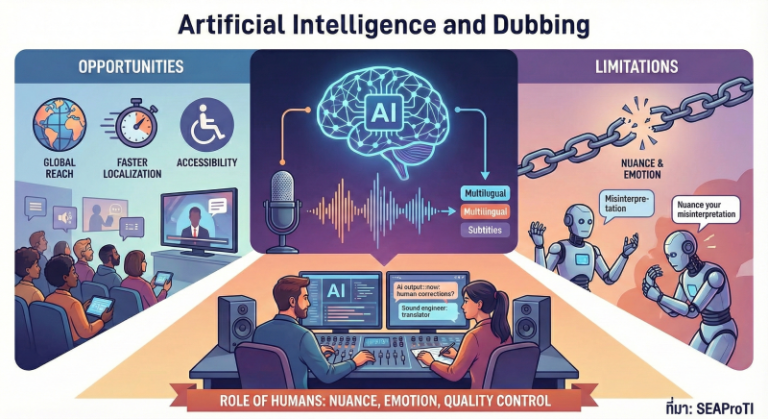

The Impact of AI on the Translation Industry

Speed and Accessibility

AI has made translation instantaneous—whether it’s text, speech, or video. For example, mobile translation apps now allow real-time conversation translation, and Zoom meetings can feature accurate live subtitles in multiple languages. This level of immediacy and accessibility was unimaginable just a few decades ago.

Quality and Context

With Neural Machine Translation (NMT) and AI systems trained on contextual data, translations now better preserve sentence structure, meaning, and tone of the original text. AI no longer simply “translates”—it now translates better in a meaningful way, producing results that are significantly more coherent and contextually accurate than earlier systems.

New Roles for Human Translators

AI has not replaced human translators. Instead, it has become a powerful support tool. Professional translators now use AI to speed up the translation process, allowing them to focus on tasks that require deeper contextual understanding—such as literary translation, legal documents, or high-level localization. AI thus reshapes the translator’s role from executor to editor, curator, and strategist.

Business and Industry Opportunities

Companies can now enter foreign markets faster and at a lower cost. For instance, a full website can be translated in just a few hours using NMT, or international conferences can be hosted with real-time AI interpreters. These capabilities make multilingual communication more scalable than ever before.

Applications Across Sectors

AI-powered translation is now used across a wide range of fields:

- Healthcare: Translating patient records or medical manuals.

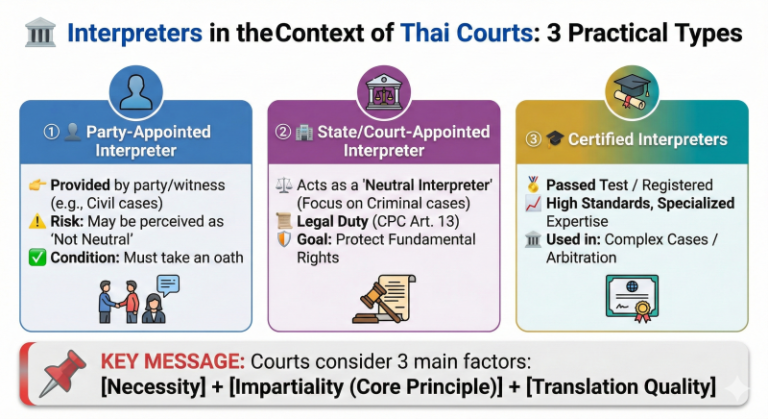

- Legal: Translating case files or providing courtroom interpretation.

- Education: Enabling multilingual online teaching and learning.

- Media: Translating films, series, and live content on streaming platforms.

Conclusion

From a small experiment in 1954, AI translation has become a cornerstone of global cross-cultural communication. The evolution from basic Machine Translation to Adaptive Machine Translation has not only improved speed and quality but has transformed every dimension of the translation industry—from the role of human translators and international market expansion to the use of technology to reach users more equally and inclusively.

The future of AI in translation may include multimodal systems capable of understanding images, audio, and text simultaneously, and systems with deep cultural contextual awareness. At the same time, key questions around ethics, accuracy, and the role of humans will continue to be central topics that the industry and translation professionals must explore together.

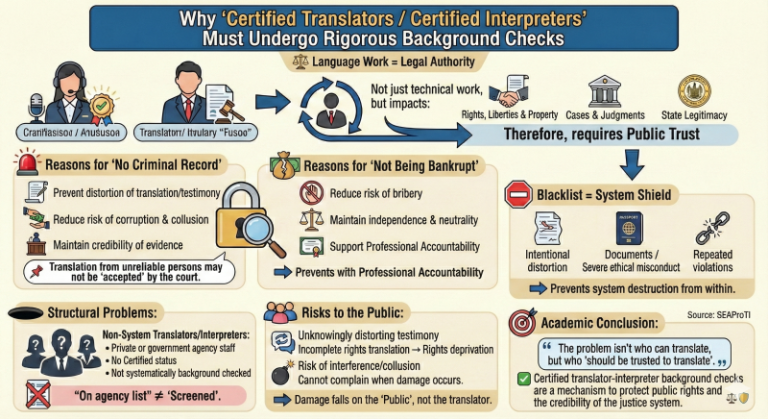

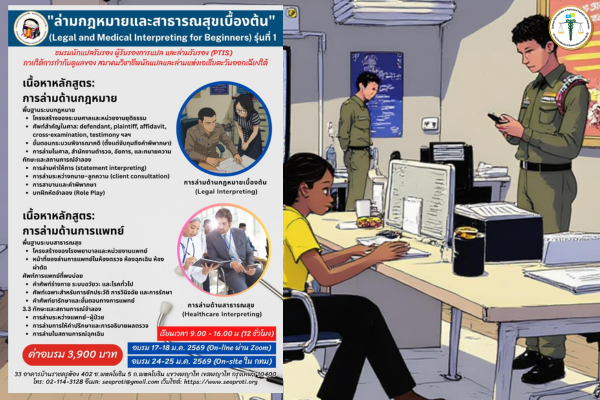

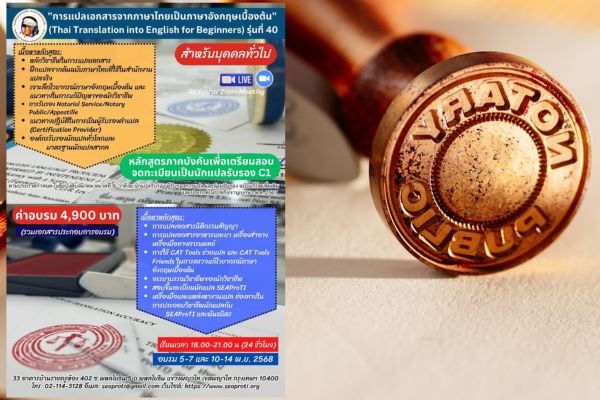

In an era where technology advances at a relentless pace, the Southeast Asian Association of Professional Translators and Interpreters (SEAProTI) remains committed to elevating the standards of the profession while embracing technology to benefit translators and interpreters. SEAProTI offers professional translation and interpreting services for important documents and events, and also provides certification to ensure accuracy and professionalism in the field. You can now access SEAProTI’s trusted services starting today.

References:

- Way, A., & Munday, D. (2004). Using automatic metrics to predict translation post-editing productivity. In Proceedings of the 9th Conference of the Association for Machine Translation in the Americas (AMTA 2004) (pp. 87–96). Association for Computational Linguistics. https://aclanthology.org/2004.amta-papers.12/

- Walker, L. (2023, March 16). The future of machine translation. BYU College of Humanities. https://hum.byu.edu/the-future-of-machine-translation

- Language Scientific. (2023, January 18). The evolution of machine translation: From rule-based systems to generative AI. Language Scientific. https://www.languagescientific.com/the-evolution-of-machine-translation-from-rule-based-systems-to-generative-ai/

About SEAProTI Certified Translators, Certification Providers, and Interpreters

The Southeast Asian Association of Professional Translators and Interpreters (SEAProTI) has published official guidelines and eligibility criteria for individuals seeking registration as Certified Translators, Translation Certification Providers, and Certified Interpreters under Chapter 9 and Chapter 10 of the Royal Thai Government Gazette, issued by the Secretariat of the Cabinet, Office of the Prime Minister, on 25 July 2024 (Vol. 141, Part 66 Ng, p. 100). Full text available at: The Royal Thai Government Gazette

Headquarters: 33 Baan Rajakhru Building, Room 402, Soi Phahonyothin 5, Phahonyothin Road, Phayathai Sub-district, Phayathai District, Bangkok 10400 Email: hello@seaproti.com Tel: (+66) 2-114-3128 (Office Hours: 9.00–17.00 HRs/Monday to Friday)

จุดเริ่มต้นของปัญญาประดิษฐ์ (AI) ในงานแปล: วิวัฒนาการ เทคโนโลยี และผลกระทบต่ออุตสาหกรรมภาษา

เรียบเรียงโดย นายกฤษติวัฒน์ นาควงษ์ และวณิชชา สุมานัส

12 สิงหาคม 2568, กรุงเทพมหานคร – การแปลเป็นศาสตร์ที่อยู่คู่มนุษยชาติมายาวนาน ทำหน้าที่เป็นสะพานเชื่อมโยงระหว่างวัฒนธรรม ภาษา และความรู้ แต่เมื่อเข้าสู่ยุคดิจิทัล การแปลด้วยระบบคอมพิวเตอร์ (Machine Translation: MT) ได้กลายมาเป็นจุดเปลี่ยนสำคัญของศาสตร์นี้ โดยเฉพาะอย่างยิ่งเมื่อปัญญาประดิษฐ์ (AI) เข้ามามีบทบาทอย่างจริงจังในช่วงปลายคริสต์ศตวรรษที่ 20 เป็นต้นมา พัฒนาการของ AI ได้ผลักดันให้เทคโนโลยีการแปลเปลี่ยนผ่านจากระบบกฎเกณฑ์แบบดั้งเดิม (Rule-based) มาสู่ระบบสถิติ (Statistical Machine Translation: SMT) และต่อเนื่องไปสู่ระบบประสาทเทียม (Neural Machine Translation: NMT) ซึ่งเป็นระบบที่สามารถเข้าใจบริบท ความหมาย และรูปแบบภาษาที่ซับซ้อนได้อย่างลึกซึ้งมากขึ้น

นอกจากความแม่นยำและความเร็วที่เพิ่มขึ้นแล้ว AI ยังทำให้การแปลเข้าถึงได้ในวงกว้าง ทั้งในภาคธุรกิจ การศึกษา และชีวิตประจำวัน อย่างไรก็ตาม การเติบโตของ AI ก็ส่งผลกระทบโดยตรงต่อบทบาทของอาชีพนักแปลทั้งในด้านความจำเป็น ทักษะ และจริยธรรมวิชาชีพ บทความนี้จึงมีจุดมุ่งหมายเพื่อศึกษาพัฒนาการของ AI ในงานแปลภาษาตั้งแต่อดีตจนถึงปัจจุบัน โดยวิเคราะห์ทั้งมิติทางเทคโนโลยี การใช้งานจริงในอุตสาหกรรม และผลกระทบที่ตามมาต่ออนาคตของวิชาชีพการแปล

จุดเริ่มต้นของการแปลด้วยระบบคอมพิวเตอร์: การทดลอง Georgetown–IBM

ประวัติของการแปลด้วยระบบคอมพิวเตอร์สามารถย้อนไปถึงการทดลองทางภาษาศาสตร์เชิงคอมพิวเตอร์ครั้งสำคัญในปี ค.ศ. 1954 ที่เรียกว่า Georgetown–IBM experiment ซึ่งถือเป็นจุดเริ่มต้นของการแปลด้วยระบบคอมพิวเตอร์ (Machine Translation: MT) อย่างเป็นทางการ โดย IBM 701 ซึ่งเป็นคอมพิวเตอร์เครื่องแรกของ IBM ได้รับการตั้งโปรแกรมให้แปลประโยคภาษารัสเซีย 60 ประโยคเป็นภาษาอังกฤษ ภายใต้ระบบที่ใช้กฎทางไวยากรณ์และพจนานุกรมที่เขียนด้วยมือทั้งหมด

การทดลอง Georgetown–IBM เมื่อวันที่ 7 มกราคม ค.ศ. 1954 นับเป็นหมุดหมายสำคัญในประวัติศาสตร์ของปัญญาประดิษฐ์ (AI) และภาษาศาสตร์คอมพิวเตอร์ โดยถือเป็นการสาธิตต่อสาธารณะครั้งแรกของการแปลภาษาโดยใช้ระบบคอมพิวเตอร์ (Machine Translation – MT) ซึ่งจัดขึ้นที่สำนักงานใหญ่ของ IBM ในนครนิวยอร์ก

ความร่วมมือระหว่างมหาวิทยาลัย Georgetown และบริษัท IBM แสดงให้เห็นถึงความเป็นไปได้ในการใช้คอมพิวเตอร์ประมวลผลภาษามนุษย์ โดยใช้คอมพิวเตอร์รุ่น IBM 701 ซึ่งถือเป็นคอมพิวเตอร์ดิจิทัลเชิงพาณิชย์รุ่นแรกของบริษัท ในการแปลประโยคภาษารัสเซียกว่า 60 ประโยคเป็นภาษาอังกฤษโดยอัตโนมัติ แม้ระบบที่ใช้จะมีขอบเขตจำกัดมาก โดยใช้เพียงกฎไวยากรณ์ 6 กฎ และคลังคำศัพท์ราว 250 คำ (รวมทั้งรากศัพท์และคำผัน) ที่เน้นเฉพาะด้านเคมีอินทรีย์ แต่การสาธิตครั้งนี้ก็มีนัยสำคัญเชิงสัญลักษณ์และกลยุทธ์เป็นอย่างยิ่ง ประโยคที่เลือกใช้ในการสาธิตได้รับการคัดสรรอย่างระมัดระวัง ครอบคลุมประเด็นด้านการเมือง กฎหมาย คณิตศาสตร์ วิชาเคมี โลหะวิทยา การสื่อสาร และการทหาร โดยพนักงานป้อนข้อมูลไม่จำเป็นต้องรู้ภาษารัสเซีย แต่สามารถใช้ระบบเพื่อแปลและพิมพ์ข้อความภาษาอังกฤษออกมาโดยอัตโนมัติ

จุดประสงค์หลักของการทดลองคือการสร้างความสนใจและการสนับสนุนจากรัฐบาลและประชาชนทั่วไป เพื่อผลักดันให้เกิดการลงทุนในด้านการวิจัยเทคโนโลยีภาษา ซึ่งถือว่าประสบผลสำเร็จอย่างยิ่ง เนื่องจากสื่อมวลชนในขณะนั้นให้ความสนใจเป็นวงกว้าง และนำเสนอภาพของ “อนาคต” ที่เครื่องจักรสามารถเข้าใจและแปลภาษามนุษย์ได้อย่างแม่นยำ ถึงแม้นว่าการแปลที่ได้จะยังห่างไกลจากความสมบูรณ์ และระบบยังไม่มีการวิเคราะห์โครงสร้างทางไวยากรณ์อย่างแท้จริง แต่การทดลองนี้ได้พิสูจน์ว่า “คอมพิวเตอร์สามารถแปลภาษาได้” ซึ่งเป็นครั้งแรกของคอมพิวเตอร์ที่ไม่ได้แค่ทำงานเกี่ยวกับตัวเลข และเป็นแรงกระตุ้นสำคัญที่นำไปสู่การวิจัยขั้นสูงในด้านปัญญาประดิษฐ์ (AI) การประมวลผลภาษาธรรมชาติ และการแปลด้วยระบบคอมพิวเตอร์ในอนาคต

ดังนั้นการทดลอง Georgetown–IBM จึงไม่เพียงเป็นจุดเริ่มต้นของ AI เท่านั้น แต่ยังเป็นจุดเริ่มต้นของการตั้งคำถามต่อศักยภาพของเครื่องจักรในการเข้าใจภาษาและความหมาย ซึ่งยังคงเป็นหัวใจสำคัญของการพัฒนา AI จนถึงปัจจุบัน

ระบบ Rule-Based MT (1950s–1980s): ฐานรากของวิศวกรรมภาษา

ช่วงปี 1950–1980 เป็นยุคของการแปลจากระบบคอมพิวเตอร์โดยอิงกฎ (Rule-Based Machine Translation: RBMT) ซึ่งเป็นระบบ MT ที่อาศัยการเขียนกฎทางภาษาศาสตร์โดยผู้เชี่ยวชาญ ครอบคลุมโครงสร้างไวยากรณ์ พจนานุกรมสองภาษา และกฎการแปลงภาษาหนึ่งไปอีกภาษาหนึ่ง RBMT ทำงานผ่านการวิเคราะห์ประโยคในระดับวากยสัมพันธ์ (Syntactic Analysis) และสัณฐานวิทยา (Morphology) ก่อนจะแปลเป็นภาษาปลายทาง โดยมีสองวิธีสำคัญ ได้แก่ วิธีที่ใช้ภาษากลางเป็นตัวเชื่อมระหว่างสองภาษา (Interlingual) ซึ่งถอดภาษาต้นทางสู่กฎที่ไม่ขึ้นกับภาษาใด จากนั้นจึงแปลเป็นภาษาปลายทาง และอีกวิธีคือ วิธีที่ถ่ายโอนโครงสร้าง (Transfer‑based) ซึ่งเป็นการแปลภาษาต้นทางไปสู่กฎเฉพาะของคู่ภาษาแล้วจึงแปลเป็นภาษาปลายทาง ซึ่งวิธีอย่างหลังได้รับความนิยมกว่าด้วยเหตุที่การออกแบบ “กฎที่ไม่ขึ้นกับภาษาใด” เป็นภารกิจที่ยากอย่างยิ่ง

ในเชิงประวัติศาสตร์ RBMT เริ่มเป็นรูปธรรมจากการสาธิต Georgetown‑IBM ในปี 1954 และได้รับแรงหนุนมหาศาลจากเงินทุนยุคสงครามเย็น อาทิ โครงการแปลเอกสารเทคนิคและการทหารของรัฐบาลสหรัฐฯ จนเกิดระบบเชิงพาณิชย์ระดับเรือธง เช่น SYSTRAN, Logos และ Ariane‑G5 ตลอดจนการลงทุนของญี่ปุ่นในโครงการคอมพิวเตอร์ The Fifth Generation Computer Project

อย่างไรก็ดี จุดแข็งของ RBMT ที่เน้นความโปร่งใสของกฎและการควบคุมแบบวิศวกรรม กลับเป็นข้อจำกัดสำคัญเมื่อเผชิญความซับซ้อนและความกำกวมของภาษาในธรรมชาติ เพราะแต่ละคู่ภาษาต้องการกฎและคำศัพท์จำนวนมหาศาล ส่งผลให้ต้นทุนการพัฒนาและการบำรุงรักษาสูง ยากแก่การขยายสู่ขอบเขตเนื้อหาหรือภาษาใหม่ อีกทั้งผลลัพธ์มักแข็งทื่อและขาดความเป็นธรรมชาติ เมื่อถึงปี 1980 วิธีที่อิงฐานคลังคำศัพท์ (Corpus‑based) ที่ใช้คลังคำศัพท์ขนาดใหญ่ของคู่ภาษาจึงเริ่มเบียด RBMT ลงจากเวทีหลัก อย่างไรก็ตาม RBMT ได้วางรากฐานให้กับการแปลด้วยระบบคอมพิวเตอร์ โดยพิสูจน์ว่าคอมพิวเตอร์สามารถประมวลผลภาษามนุษย์ผ่านความรู้ภาษาศาสตร์เชิงระบบ อันเป็นก้าวแรกสู่การพัฒนาการในยุคถัดไป

การปฏิวัติด้วยสถิติ (Statistical MT: 1990–2010)

เมื่อคอมพิวเตอร์มีพลังการประมวลผลสูงขึ้นในช่วงทศวรรณ 1980 นักวิจัยจึงเริ่มพัฒนาการการแปลด้วยระบบคอมพิวเตอร์จากสถิติ (Statistical Machine Translation: SMT) โดยอาศัยการเรียนรู้จาก Parallel Corpora หรือชุดข้อมูลคู่ภาษาที่จับคู่คำแปลของกันและกัน ดังนั้น SMT จึงไม่ได้พึ่งพากฎทางไวยากรณ์ที่เขียนด้วยมืออีกต่อไป แต่ใช้ความน่าจะเป็นทางสถิติเพื่อคาดเดาคำแปลที่มีแนวโน้มเข้ากันได้มากที่สุด

การแปลด้วยระบบคอมพิวเตอร์จากสถิติ (Statistical Machine Translation: SMT) ซึ่งเริ่มมีบทบาทตั้งแต่ปี 1990 จนถึงช่วงปี 2010 นับเป็นจุดเปลี่ยนสำคัญที่ยกระดับขอบเขตและคุณภาพของการแปลด้วยระบบอัตโนมัติจากยุค RBMT สู่ยุคที่ขับเคลื่อนด้วยข้อมูล (Data‑Driven) อย่างเต็มรูปแบบ โดย SMT อาศัยการเรียนรู้จากชุดข้อมูลคู่ภาษาขนาดใหญ่ เพื่อสร้างแบบจำลองความน่าจะเป็นระหว่างวลีหรือหน่วยคำในภาษาต้นทางและภาษาปลายทาง ระบบจึงสามารถคำนวณความเป็นไปได้ของประโยคที่จะแปลได้เองโดยไม่ต้องพึ่งพากฎไวยากรณ์ที่มนุษย์เขียนขึ้น จุดเริ่มต้นของงานวิจัยนี้มาจากทีมศูนย์วิจัย โธมัส เจ วัตสัน ของ IBM ซึ่งได้รับแรงบันดาลใจจากแนวคิดข้อมูลของ โคลด แชนนอน และข้อเสนอว่าด้วยการประยุกต์สถิติเพื่อถอดรหัสภาษา ของ วอร์เรน วีเวอร์ ตั้งแต่ปี 1949

ความก้าวหน้าในทศวรรตที่ 1990 สอดรับกับการเกิดขึ้นของคอมพิวเตอร์ที่มีสมรรถนะสูงและมีคลังข้อมูลแบบดิจิทัล ทำให้โครงการระดับชาติ อาทิ Verbmobil ในเยอรมนี หรือโครงการของ DARPA ในสหรัฐฯ สามารถผลักดัน SMT ทั้งในการแปลข้อความและคำพูด

ในเชิงพาณิชย์นั้น ระบบ SMT ถูกนำไปใช้อย่างจริงจังและแพร่หลาย เช่น Google Translate (ค.ศ. 2007–2016) และบริการของ SYSTRAN ซึ่งขยายตลาดการแปลอัตโนมัติให้กว้างขวางเกินขอบเขต แม้ SMT จะยกระดับขอบเขตที่ครอบคลุมและลดเวลาเตรียมระบบลงอย่างมหาศาล แต่ก็ยังติดข้อจำกัดด้านความเป็นธรรมชาติของภาษา การประเมินโครงสร้างไวยากรณ์ที่อยู่ไกลกันในประโยค (Long‑distance Dependencies) และการพึ่งพาคลังข้อมูลที่ใหญ่และคุณภาพสูง ดังนั้นการมาถึงของการแปลด้วยระบบคอมพิวเตอร์จากเครือข่ายประสาทเทียม (Neural Machine Translation: NMT) ในช่วงปี 2010 ซึ่งใช้โครงข่ายประสาทเทียมเพื่อประมวลผลประโยคทั้งประโยค จึงค่อย ๆ เข้ามาแทนที่ SMT

อย่างไรก็ตาม SMT ได้พิสูจน์ศักยภาพว่าการแปลด้วยระบบคอมพิวเตอร์จากสถิติมีพลังเพียงพอในการทำให้การแปลด้วยระบบคอมพิวเตอร์เริ่มสามารถเรียนรู้ภาษาได้บางส่วนโดยไม่ต้องใช้มนุษย์ และได้ปูรากฐานมาสู่การพัฒนาระบบการแปลอัตโนมัติในปัจจุบันอย่างไม่อาจปฏิเสธได้

Neural Machine Translation (NMT): จุดเปลี่ยนสู่ยุคสมัยใหม่

ช่วงกลางทศวรรษที่ 2010 เป็นยุคของ Neural Machine Translation (NMT) ที่ใช้ระบบโครงข่ายประสาทเทียม (Neural Networks) โดยเฉพาะระบบโครงข่ายประสาทเทียมแบบวนซ้ำ หรือ Recurrent Neural Networks (RNNs) และต่อมาเปลี่ยนมาใช้ระบบการเรียนรู้ความสัมพันธ์ระหว่างคำในประโยคทั้งหมดพร้อมกัน หรือ Transformer Architecture ซึ่ง Google เป็นผู้นำในการพัฒนา นับเป็นก้าวกระโดดของวงการการแปลด้วยระบบคอมพิวเตอร์ โดยอาศัยโครงข่ายประสาทเทียมที่เรียนรู้ความสัมพันธ์เชิงบริบทของประโยคทั้งหมด แทนการแยกประมวลผลเป็นคำหรือวลีเฉพาะจุดเหมือนวิธีการก่อนหน้า

แม้ว่าการบุกเบิกการแปลด้วยระบบคอมพิวเตอร์จากโครงข่ายประสาทเทียม (NMT) ในช่วงปี 1980 ถึง 1990 อาทิเช่น โมเดล Feed‑Forward ของ โรเบิร์ต บี อัลเลน (1987) และ Recursive Auto‑associative Memory Networks จะพิสูจน์ว่าแนวคิดนี้ได้ผล แต่ข้อจำกัดด้านพลังการประมวลผลและข้อมูลของ NMT ทำให้ SMT ยังคงครองพื้นที่วิจัยมาอีกยาวนาน

กระทั่งปี 2014 ทางทีม Google ได้นำเสนอโมเดล Sequence‑to‑sequence (seq2seq) ที่ใช้ RNNs เข้ารหัสประโยคเป็นข้อมูลข้อความในรูปแบบตัวเลข หรือที่เรียกว่า เวกเตอร์ (Vector) แล้วถอดรหัสเป็นภาษาปลายทาง พร้อมกลไกที่ช่วยให้ตัวถอดรหัสสามารถมองย้อนกลับไปยังคำในประโยคต้นทาง (Attention) ที่ช่วยทำให้โมเดลโฟกัสตำแหน่งคำสำคัญระหว่างการแปล ส่งผลให้คุณภาพข้อความมีความลื่นไหลและสละสลวยยิ่งขึ้น

และต่อมาการถือกำเนิดของ Transformer Architecture ในปี 2017 ได้ยกระดับทั้งความแม่นยำและความเร็วอย่างมีนัยสำคัญ ทำให้ NMT มีศักยภาพรองรับภาษาหลากหลายด้วยหน่วยความจำต่ำกว่าวิธีที่ใช้สถิติ และสามารถจัดการโครงสร้างไวยากรณ์ที่อยู่ไกลกันในประโยค (Long‑distance Dependencies) ได้ดี นอกจากนี้การฝึกแบบ end‑to‑end หรือกระบวนการการทำงานตั้งแต่ต้นจนจบโดยไม่มีขั้นตอนแยกย่อย ยังช่วยลดภาระการออกแบบคุณลักษณะเชิงภาษาของมนุษย์ ขณะเดียวกันยังเปิดทางสู่การประยุกต์ใช้งานด้านอื่น เช่น การแปลเสียง การสรุปข้อความ และแชตบอตอัจฉริยะ

การยอมรับในอุตสาหกรรมสะท้อนผ่านการที่ Google Translate เปลี่ยนจาก SMT เป็น NMT ในปี 2016 ตามมาด้วย Microsoft Translator, DeepL และ Baidu ทำให้ NMT กลายเป็นมาตรฐานของการแปลยุคใหม่ ด้วยคุณสมบัติที่ให้ผลลัพธ์ใกล้เคียงภาษามนุษย์ และปรับตัวได้ดีต่อบริบทที่ไม่เคยเห็นมาก่อน ดังนั้น NMT จึงมิใช่เพียง “วิธี” แต่เป็นเสาหลักของระบบประมวลภาษาธรรมชาติแห่งยุคปัญญาประดิษฐ์ (AI) ที่ยังคงพัฒนาไม่หยุดยั้งในปัจจุบัน

AI ยุคใหม่: การแปลแบบเรียลไทม์และระบบที่ปรับเปลี่ยนได้ตามสถานการณ์

ตั้งแต่ปี 2020 เป็นต้นมา เราเข้าสู่ยุคของการแปลด้วยระบบคอมพิวเตอร์แบบที่ปรับเปลี่ยนได้ตามสถานการณ์ (Adaptive MT) และ การแปลแบบเรียลไทม์โดยใช้ AI (Real-time AI Translation) ซึ่งระบบสามารถเรียนรู้จาก Feedback ของผู้ใช้ และปรับรูปแบบการแปลให้เข้ากับบริบทเฉพาะ เช่น โทนเสียง ศัพท์เฉพาะ หรือแม้กระทั่งสำเนียงผู้พูด

การแปลด้วยระบบคอมพิวเตอร์แบบที่ปรับเปลี่ยนได้ตามสถานการณ์ (Adaptive Machine Translation: AMT) เป็นความก้าวหน้าล่าสุดของเทคโนโลยีการแปลที่ผสานโมเดล Neural Machine Translation (NMT) เข้ากับกระบวนการเรียนรู้ Real-time Learning โดยเริ่มจากโมเดลฐานที่ฝึกด้วย Parallel Corpora แล้วให้ระบบเรียนรู้จากการแก้ไขของมนุษย์ (Post‑editing) ผลคือโมเดลสามารถปรับการประมวณผลภายในทันทีที่ผู้ใช้ยืนยันหรือแก้ไขประโยคแปล ทำให้คุณภาพดีขึ้นอย่างต่อเนื่องโดยไม่ต้องรอฝึกใหม่เป็นรอบ ๆ ดังเช่นระบบ MT แบบดั้งเดิม

จุดเด่นของ AMT ได้แก่

(1) Real‑Time Learning ทุกการแก้ไขสะท้อนสู่ผลลัพธ์ประโยคถัดไปทันที ลดข้อผิดพลาดซ้ำซาก

(2) Human‑in‑the‑Loop รักษาบทบาทนักแปลมืออาชีพ และขณะเดียวกันก็ยกระดับประสิทธิภาพได้สูงถึง 30% ถึง 60%

(3) Customization ปรับให้ตรงโทน ศัพท์เทคนิค และสไตล์ผู้ใช้รายบุคคล

(4) Cost Efficiency ลดภาระ post‑editing และค่าใช้จ่ายในการฝึกแบบการประมวณผลข้อมูลจำนวนมากในชุดเดียว (Batch Model)

ตัวอย่างเชิงพาณิชย์ที่ใช้งานจริง เช่น ModernMT, Lilt, Amazon Translate Adaptive, SYSTRAN Pure Neural Server และ Language Weaver ซึ่งต่างแสดงให้เห็นว่า AMT สามารถบูรณาการกับหน่วยความจำการแปล (TM) และฐานคำศัพท์เพื่อเสริมศักยภาพการ Localization ได้ยืดหยุ่นกว่าเดิม

ความสามารถในการประมวลผลข้อมูลย้อนกลับทันทีนี้ทำให้ AMT เหมาะกับเอกสารที่มีความเสี่ยงสูงต่อความผิดพลาด เช่น ด้านกฎหมาย การแพทย์ และวิศวกรรม ตลอดจนการแปลที่ต้องการความรวดเร็ว เช่น การแปลภาษาสด (Live‑chat) หรือการอัปเดตคู่มือผลิตภัณฑ์รายวัน ดังนั้น AMT จึงมิได้เป็นเพียงการปรับปรุงคุณภาพการแปลเชิงปริมาณเท่านั้น แต่ยังเป็นการเปลี่ยนกรอบคิดจาก “เครื่องมือช่วยแปล” ไปสู่ “AI แปลภาษา” ที่เรียนรู้จากมนุษย์และเติบโตไปพร้อมกับความต้องการภาษาในโลกยุคโลกาภิวัตน์

ผลกระทบของ AI ต่ออุตสาหกรรมการแปล

ความเร็วและการเข้าถึง

AI ทำให้การแปลเป็นเรื่องที่ทำได้ทันทีไม่ว่าจะเป็นข้อความ เสียง หรือวิดีโอ ตัวอย่างเช่น แอปแปลภาษาในมือถือที่สามารถแปลบทสนทนาได้แบบเรียลไทม์ หรือระบบแปลคำบรรยายสดในประชุม Zoom ได้อย่างแม่นยำในหลายภาษา

คุณภาพและบริบท

ระบบ NMT และ AI ที่เรียนรู้จากข้อมูลบริบททำให้สามารถรักษาโครงสร้าง ความหมาย และโทนของต้นฉบับได้ดีกว่าเดิมอย่างมาก ทำให้ AI ไม่ใช่แค่ “แปลได้” แต่แปลได้ “ดีขึ้น” อย่างมีนัยสำคัญ

บทบาทใหม่ของนักแปล

AI ไม่ได้มาแทนที่นักแปล แต่กลายเป็นเครื่องมือช่วย นักแปลมืออาชีพใช้ AI เพื่อเร่งกระบวนการ ทำให้พวกเขาสามารถโฟกัสที่งานแปลที่ต้องใช้ความเข้าใจบริบทสูง เช่น งานแปลวรรณกรรม กฎหมาย หรือการ Localization มากขึ้น

โอกาสทางธุรกิจและอุตสาหกรรม

บริษัทสามารถเข้าถึงตลาดต่างประเทศได้เร็วขึ้นด้วยต้นทุนต่ำลง เช่น การแปลเว็บไซต์ทั้งระบบภายในไม่กี่ชั่วโมงด้วย NMT หรือการจัดสัมมนาระหว่างประเทศพร้อมล่าม AI แบบเรียลไทม์

การประยุกต์ในภาคส่วนต่าง ๆ

AI แปลภาษาถูกนำไปใช้ในหลายภาคส่วน เช่น

- ด้านการแพทย์: แปลประวัติผู้ป่วยหรือคู่มือใช้งานทางการแพทย์

- ด้านกฎหมาย: แปลสำนวนคดีหรือล่ามในศาล

- ด้านการศึกษา: การสอนออนไลน์แบบพหุภาษา

- ด้านสื่อ: การแปลภาพยนตร์ ซีรีส์ หรือเนื้อหาสดในแพลตฟอร์มสตรีมมิง

บทสรุป

จากการทดลองเล็ก ๆ เมื่อปี 1954 วันนี้การแปลด้วย AI ได้กลายเป็นแกนหลักของการสื่อสารระหว่างวัฒนธรรมทั่วโลก วิวัฒนาการจากระบบ Machine Translation ไปจนถึง Adaptive Machine Translation ไม่เพียงแต่เพิ่มความเร็วและคุณภาพ แต่ยังเปลี่ยนแปลงอุตสาหกรรมการแปลในทุกมิติ ทั้งบทบาทของนักแปล การขยายตลาดระหว่างประเทศ และโอกาสในการใช้เทคโนโลยีเพื่อเข้าถึงผู้ใช้ทุกกลุ่มอย่างเท่าเทียม

อนาคตของ AI ในการแปลอาจรวมถึงระบบ Multi-modal ที่เข้าใจภาพ เสียง และข้อความพร้อมกัน รวมถึงระบบที่เข้าใจบริบทวัฒนธรรมอย่างลึกซึ้ง ในขณะเดียวกัน การคงไว้ซึ่งจริยธรรม ความถูกต้อง และบทบาทมนุษย์ จะยังคงเป็นคำถามสำคัญที่ภาคอุตสาหกรรมและวิชาชีพการแปลต้องร่วมกันขบคิด

ในยุคที่เทคโนโลยีเดินหน้าไปอย่างไม่มีวันหยุด สมาคมวิชาชีพนักแปลและล่ามแห่งเอเชียตะวันออกเฉียงใต้ SEAProTI ยังคงพร้อมยกระดับวิชาชีพ ควบคู่ไปกับการประยุคใช้เทคโนโลยีให้เกิดประโยชน์แก่วิชาชีพนักแปลและล่ามต่อไป SEAProTI มีบริการแปลเอกสารสำคัญและล่าม ร่วมทั้งยังช่วยรับรองนักแปลและล่าม เพื่อความถูกต้องและเป็นมืออาชีพของวิชาชีพ สามารถใช้บริการ SEAProTI ได้ตั้งแต่วันนี้เป็นต้นไป

อ้างอิง:

- Way, A., & Munday, D. (2004). Using automatic metrics to predict translation post-editing productivity. In Proceedings of the 9th Conference of the Association for Machine Translation in the Americas (AMTA 2004) (pp. 87–96). Association for Computational Linguistics. https://aclanthology.org/2004.amta-papers.12/

- Walker, L. (2023, March 16). The future of machine translation. BYU College of Humanities. https://hum.byu.edu/the-future-of-machine-translation

- Language Scientific. (2023, January 18). The evolution of machine translation: From rule-based systems to generative AI. Language Scientific. https://www.languagescientific.com/the-evolution-of-machine-translation-from-rule-based-systems-to-generative-ai/

เกี่ยวกับนักแปลรับรอง ผู้รับรองการแปล และล่ามรับรองของสมาคมวิชาชีพนักแปลและล่ามแห่งเอเชียตะวันออกเฉียงใต้

สมาคมวิชาชีพนักแปลและล่ามแห่งเอเชียตะวันออกเฉียงใต้ (SEAProTI) ได้ประกาศหลักเกณฑ์และคุณสมบัติผู้ที่ขึ้นทะเบียนเป็น “นักแปลรับรอง (Certified Translators) และผู้รับรองการแปล (Translation Certification Providers) และล่ามรับรอง (Certified Interpreters)” ของสมาคม หมวดที่ 9 และหมวดที่ 10 ในราชกิจจานุเบกษา ของสำนักเลขาธิการคณะรัฐมนตรี ในสำนักนายกรัฐมนตรี แห่งราชอาณาจักรไทย ลงวันที่ 25 ก.ค. 2567 เล่มที่ 141 ตอนที่ 66 ง หน้า 100 อ่านฉบับเต็มได้ที่: นักแปลรับรอง ผู้รับรองการแปล และล่ามรับรอง

สำนักงานใหญ่: อาคารบ้านราชครุ เลขที่ 33 ห้อง 402 ซอยพหลโยธิน 5 ถนนพหลโยธิน แขวงพญาไท เขตพญาไท กรุงเทพมหานคร 10400 อีเมล: hello@seaproti.com โทรศัพท์: (+66) 2-114-3128 (เวลาทำการ: วันจันทร์–วันศุกร์ เวลา 9.00–17.00 น.)